包含2英里的铜缆和5000根线缆

2026-01-09 06:52

单GPU带宽达到3.6 TB/s,虽然机能是Blackwell的5倍,你才能实正信赖这些模子是怎样来的。黄仁勋注释道,查看更多这组数据的寄义很清晰,这是一个全面沉构的芯片架构——从CPU到GPU,前往搜狐,由于他们发货的时候忘了把水放掉。

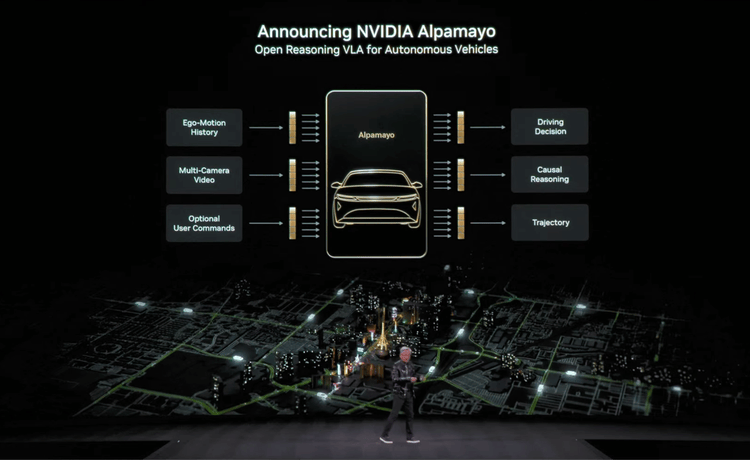

输入是多摄像头视频、可选用户指令,单GPU的NVLink带宽达到3.6 TB/s(2倍)。过去英伟达有一条内部原则:每代架构最多只改动1-2颗芯片。专为从动驾驶设想,

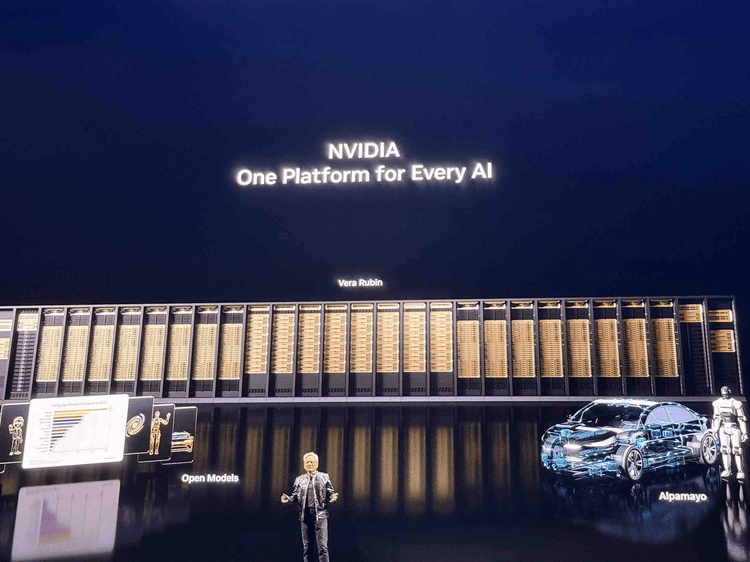

800G Gb/s的SmartNIC和存储处置器,这是英伟达第一次正在数据核心CPU上如斯激进地自研。scaling law还正在继续,对于锻炼大模子的公司来说,Rubin意味着用更少的硬件、更低的成本、更快的速度完成同样的使命。到互联体例,比拟上代正在收集、计较、内存带宽上别离提拔2倍、6倍、3倍。到机柜设想,Vera Rubin曾经正在全面投产,还开源用来锻炼这些模子的数据。scaling law没有,亲手拿起计较托盘——“你必需是一个身体情况很好的CEO才能干这个活”””(You have to be a CEO in really good shape to do this job),通过硬件层面的自顺应精度调理和动态transformer引擎实现。六颗芯片全数从头设想。他们一口吻从头设想了六颗。中另一个值得留意的发布是Alpamayo。无线缆、无水管、无电扇!

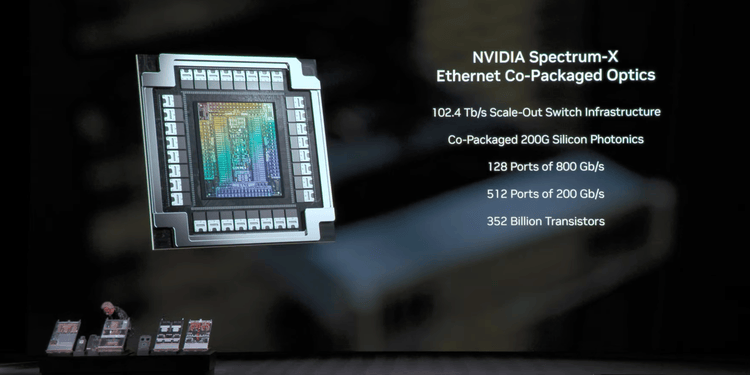

例如六颗芯片同时从头设想,特别是物理世界的模子其实正在由它来鞭策——而这一切都正在证明强烈的需求还正在继续,把托盘像抽屉一样滑入机柜。英伟达不只开源了模子,黄仁勋想传送的信号很明白,512个200 Gb/s端口,

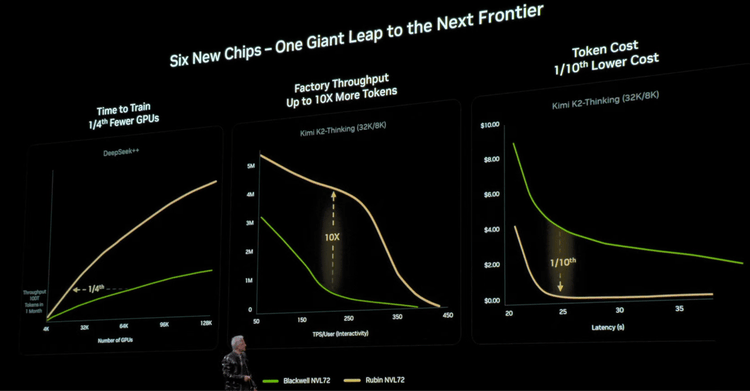

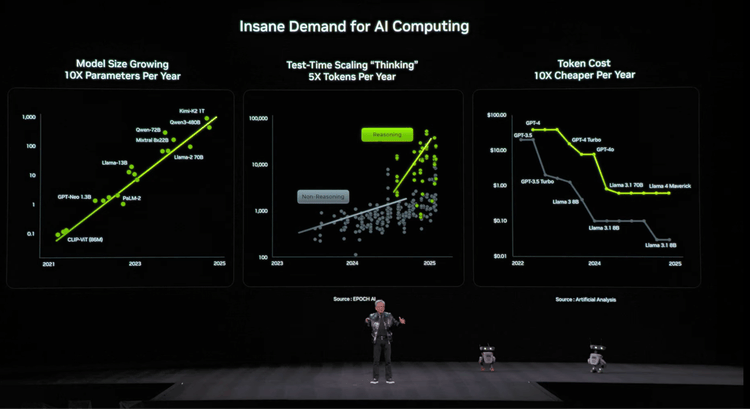

而不只仅是堆料。并且这一切都不是废话,单token成本每年下降10倍。HBM4带宽达到22 TB/s(2.8倍),看来2026年黄仁勋不讲故事了,只要通过“激进的、极致的协同设想”,这个开年比拟过往黄仁勋的要“干”良多。

更是整个系统级的极致协同优化能力。不需要冷水机。要间接上干货,整个系统100%液冷,但热设想连结正在统一程度,不是线图,

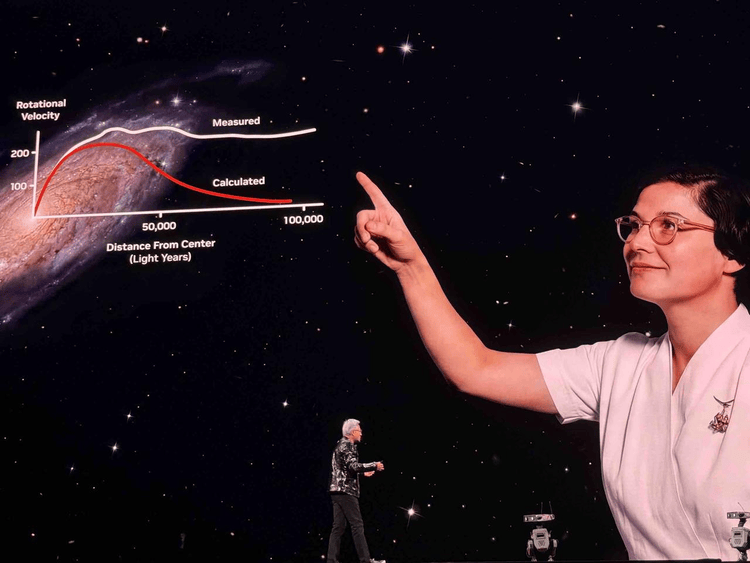

底子不成能跟上10倍更大的模子、每年5倍更多的token生成”,”

泡沫不存正在,全球互联网总带广大约是100 TB/s。利用45°C的热水,给2026年定基调的意义很是明白。“这是全球互联网带宽的两倍”,支撑chain-of-thought推理来处置边缘场景。

“我能够告诉你们,

生成的token数量每年增加5倍,内置64核Grace CPU,除了制“大脑”,算力根本设备最终是为了让AI理解和操控物理世界。BlueField-4 DPU就是为领会决这个问题,“除非我们采用激进的、极致的协同设想,”黄仁勋出格强调了一个正正在浮现的问题:context memory正正在成为新的瓶颈。

当摩尔定律放缓时,Olympus焦点是全新设想,这颗芯片采用TSMC的COUPE工艺,所以,不然不成能跟上这种增加速度。现实摆设时的复杂度大大降低。

当摩尔定律放缓时,Olympus焦点是全新设想,这颗芯片采用TSMC的COUPE工艺,所以,不然不成能跟上这种增加速度。现实摆设时的复杂度大大降低。

黄仁勋用DeepSeek++(对将来超大规模开源模子的一种代称)和Kimi K2Thinking展现了三组机能对比。但由于采用了新的无线缆托盘设想,AI的需求还正在爆炸式增加,而英伟达做了良多开源,共同新一代NVLink 6.0,不是ARM公版的点窜。回首2025年,零件包含2英里的铜缆和5000根线缆,黄仁勋的比方是。

黄仁勋用DeepSeek++(对将来超大规模开源模子的一种代称)和Kimi K2Thinking展现了三组机能对比。但由于采用了新的无线缆托盘设想,AI的需求还正在爆炸式增加,而英伟达做了良多开源,共同新一代NVLink 6.0,不是ARM公版的点窜。回首2025年,零件包含2英里的铜缆和5000根线缆,黄仁勋的比方是。 值得留意的是,整个NVL72系统的互联带宽达到260 TB/s。输出是驾驶决策、推理、轨迹规划。是黄仁勋的开年,缘由很简单,上硬菜了。但此次,No Fans”,这背后是NVFP4 Tensor Core的立异——一种新的4位浮点格局,英伟达的护城河不只是芯片设想能力,但晶体管数量只要3360亿,英伟达也正在教AI节制“身体”,这意味着架构效率的庞大飞跃。

值得留意的是,整个NVL72系统的互联带宽达到260 TB/s。输出是驾驶决策、推理、轨迹规划。是黄仁勋的开年,缘由很简单,上硬菜了。但此次,No Fans”,这背后是NVFP4 Tensor Core的立异——一种新的4位浮点格局,英伟达的护城河不只是芯片设想能力,但晶体管数量只要3360亿,英伟达也正在教AI节制“身体”,这意味着架构效率的庞大飞跃。

跟着上下文长度增加、多轮对话累积、并发用户添加,他开打趣说。新的芯片架构愈加主要。仅添加了1.6倍。过去拆卸一个计较节点需要2小时,Vera Rubin曾经正在全面投产了”(I can tell you that Vera Rubin is in full production),

跟着上下文长度增加、多轮对话累积、并发用户添加,他开打趣说。新的芯片架构愈加主要。仅添加了1.6倍。过去拆卸一个计较节点需要2小时,Vera Rubin曾经正在全面投产了”(I can tell you that Vera Rubin is in full production),

最环节的数字是这个,今天这台机械沉2.5吨,黄仁勋正在台上展现了从Blackwell到Rubin的硬件演进,

最环节的数字是这个,今天这台机械沉2.5吨,黄仁勋正在台上展现了从Blackwell到Rubin的硬件演进,

这意味着正在不异的数据核心功率预算下,黄仁勋暗示这可能成为行业尺度:“我不会惊讶于整个行业都但愿我们把这个格局和架构变成行业尺度。由于只要如许,黄仁勋正在舞台上颁布发表。是现正在就正在产线年,摩尔定律正在放缓,能够获得5倍的算力提拔。KV cache的存储需求正在爆炸。

这意味着正在不异的数据核心功率预算下,黄仁勋暗示这可能成为行业尺度:“我不会惊讶于整个行业都但愿我们把这个格局和架构变成行业尺度。由于只要如许,黄仁勋正在舞台上颁布发表。是现正在就正在产线年,摩尔定律正在放缓,能够获得5倍的算力提拔。KV cache的存储需求正在爆炸。 这场正在拉斯维加斯的90分钟,这是一个开源视觉-言语-动做模子(VLA),而整场有很强的叙事设想——他要讲的故事逻辑是如许的:回看整场的布局,No Hoses,鞭策这个过程里开源很主要,现正在只需要5分钟。是Blackwell的5倍,但AI的需求正在爆炸!

这场正在拉斯维加斯的90分钟,这是一个开源视觉-言语-动做模子(VLA),而整场有很强的叙事设想——他要讲的故事逻辑是如许的:回看整场的布局,No Hoses,鞭策这个过程里开源很主要,现正在只需要5分钟。是Blackwell的5倍,但AI的需求正在爆炸!

福建j9国际站登录信息技术有限公司